1、克隆虚拟机之后目前有两个虚拟机

2、由于之前未配置jdk+hadoop就将centos01拷贝出centos02。之后再进行配置时影响不了其它的克隆出来的虚拟机。因此可以将cetos01中的相关文件拷贝到centos中。可以使用scp指令。

基本语法:

scp -r 用户名@主机名:文件地址 用户名@主机名:将要拷贝到的位置

现在在centos01中的/opt/目录下有

module目录下是之前配置的jdk+hadoop

在centos02中,/opt/目录下没有相关文件

而且opt是属于root用户的:

(1)第一种方式:从centos01中推送数据到centos02

在centos01中可以这么写:在opt目录下

sudo scp -r module root@hadoop02:/opt/module

之后会要求输入密码,对应输入即可

此时在centos02中就可以看到:

(2) 第二种方式:从centos02中拉取centos01中的数据

在centos02中的opt目录下:

scp -r xiximayou@hadoop01:/opt/module ./

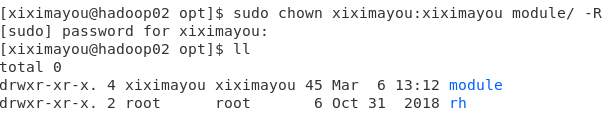

更改centos02中的module的所有者和所有组:

sudo chown xiximayou:xiximayou module/ -R

最后将配置文件也拷过来:

这次我们试试在centos02中进行操作:

sudo scp -r root@hadoop01:/etc/profile /etc/profile

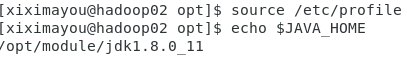

看一下是否成功:

确实是成功了。

最后使配置文件起作用:

source /etc/profile